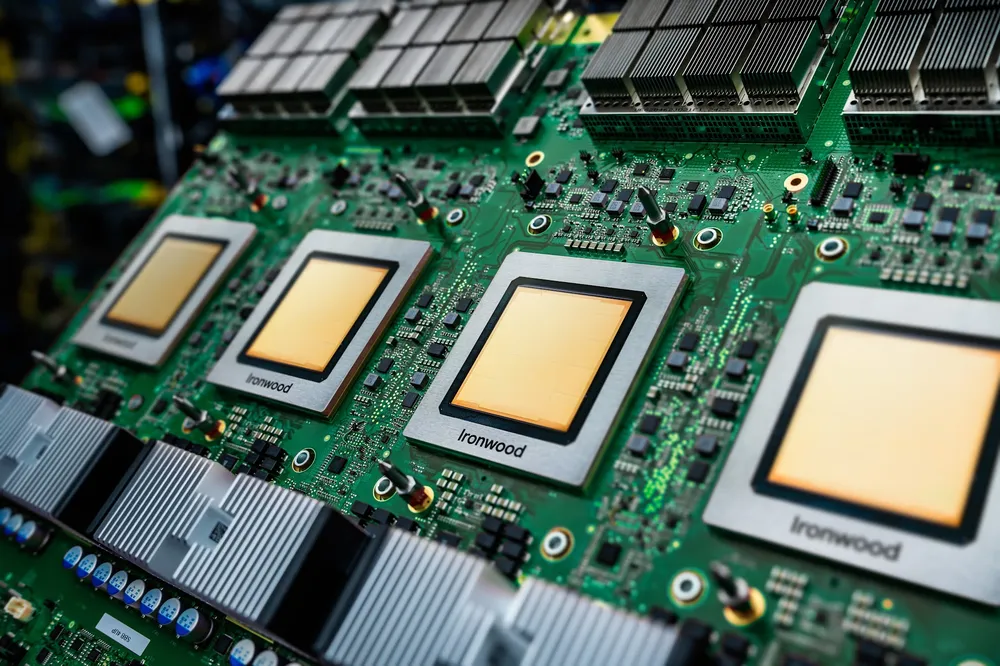

Các mô hình AI tiên tiến nhất hiện nay, như những mô hình cung cấp năng lượng cho tư duy và tính toán phức tạp, cần tốc độ và hiệu quả từ phần cứng cung cấp năng lượng cho chúng. Đó là lý do tại sao tại Cloud Next vào tháng 4, chúng tôi đã tiết lộ Gỗ sắt, Bộ xử lý Tensor thế hệ thứ bảy (TPU) của chúng tôi.

Ironwood là TPU mạnh mẽ, có khả năng và tiết kiệm năng lượng nhất của chúng tôi, được thiết kế để cung cấp năng lượng cho các mô hình AI suy luận, tư duy trên quy mô lớn.

Bằng cách hoạt động như một bộ xử lý song song cực kỳ hiệu quả, Ironwood vượt trội trong việc quản lý các phép tính lớn và giảm thiểu đáng kể thời gian bên trong cần thiết để dữ liệu di chuyển qua chip. Bước đột phá này tăng tốc đáng kể AI phức tạp, làm cho các mô hình chạy nhanh hơn và mượt mà hơn đáng kể trên đám mây của chúng ta.

Và bây giờ, Ironwood đang ở đây cho khách hàng của Cloud.

Dưới đây là ba điều cần biết về nó.

1. Nó được xây dựng có mục đích cho thời đại suy luận

Khi trọng tâm của ngành chuyển từ đào tạo các mô hình biên giới sang cung cấp năng lượng cho các tương tác hữu ích, đáp ứng với chúng, Ironwood cung cấp phần cứng thiết yếu. Nó được xây dựng tùy chỉnh cho khối lượng lớn, độ trễ thấp Suy luận AI và phục vụ mô hình. Nó cung cấp hơn 4X hiệu suất tốt hơn trên mỗi chip cho cả khối lượng công việc đào tạo và suy luận so với thế hệ cuối cùng của chúng ta, biến Ironwood trở thành silicon tùy chỉnh mạnh mẽ và tiết kiệm năng lượng nhất của chúng tôi cho đến nay.

2. Đó là một mạng lưới quyền lực khổng lồ

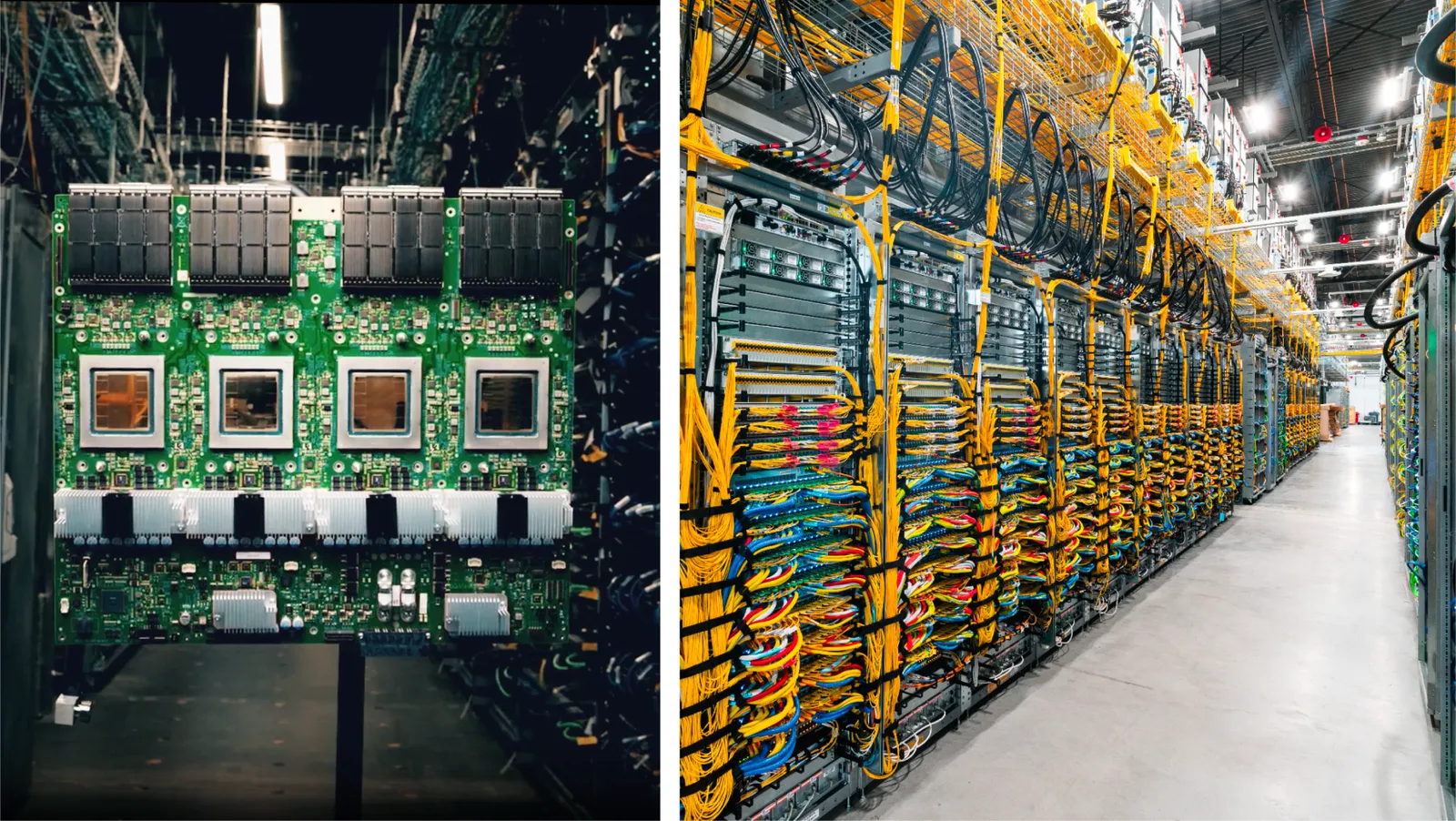

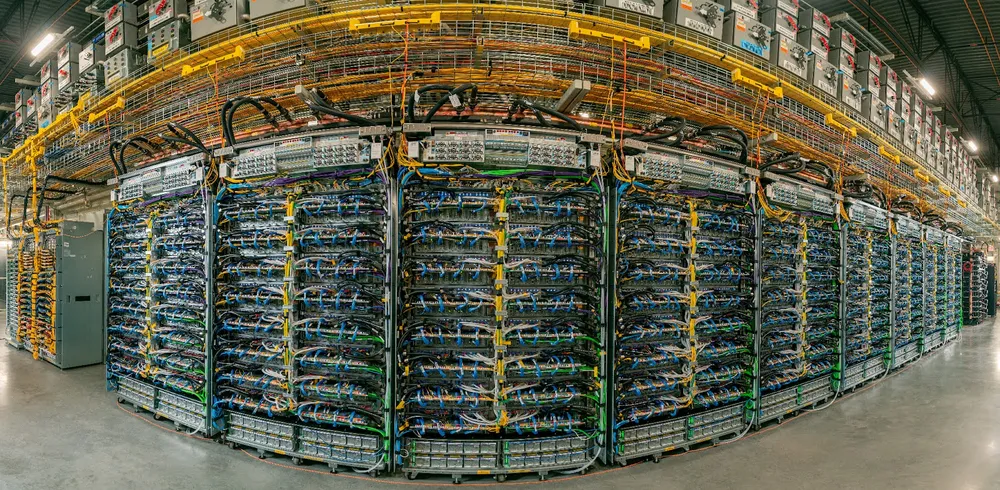

TPU là thành phần chính của Siêu máy tính AI, hệ thống siêu máy tính tích hợp của chúng tôi được thiết kế để nâng cao hiệu suất và hiệu quả ở cấp độ hệ thống trên toàn bộ máy tính, mạng, lưu trữ và phần mềm. Về cốt lõi, hệ thống nhóm các TPU riêng lẻ thành các đơn vị được kết nối với nhau được gọi là nhóm. Với Ironwood, chúng tôi có thể mở rộng quy mô lên tới 9.216 chip trong một siêu máy. Các chip này được liên kết thông qua mạng Inter-Chip Interconnect (ICI) đột phá hoạt động ở tốc độ 9,6 Tb/s.

Một phần của siêu pod Ironwood, kết nối trực tiếp 9.216 TPU Ironwood trong một miền duy nhất.

Khả năng kết nối khổng lồ này cho phép hàng nghìn chip giao tiếp và truy cập nhanh chóng vào Bộ nhớ băng thông cao (HBM) dùng chung 1,77 Petabyte đáng kinh ngạc, khắc phục tắc nghẽn dữ liệu cho ngay cả những mẫu máy đòi hỏi khắt khe nhất. Hiệu quả này làm giảm đáng kể số giờ tính toán và năng lượng cần thiết cho việc đào tạo và vận hành các dịch vụ AI tiên tiến.

3. Nó được thiết kế cho AI với AI

Ironwood là kết quả của một vòng lặp liên tục tại Google, nơi các nhà nghiên cứu ảnh hưởng đến thiết kế phần cứng và phần cứng tăng tốc nghiên cứu. Trong khi các đối thủ cạnh tranh dựa vào các nhà cung cấp bên ngoài, khi Google DeepMind cần một tiến bộ kiến trúc cụ thể cho một mô hình như Gemini, họ cộng tác trực tiếp với các đối tác kỹ sư TPU của h. Do đó, các mô hình của chúng tôi được đào tạo trên các thế hệ TPU mới nhất, thường thấy tốc độ tăng tốc đáng kể so với phần cứng trước đó. Các nhà nghiên cứu của chúng tôi thậm chí còn sử dụng AI để thiết kế thế hệ chip tiếp theo —, một phương pháp được gọi là AlphaChip — đã sử dụng phương pháp học tăng cường để tạo ra các bố cục vượt trội cho ba thế hệ TPU gần đây nhất, bao gồm cả Ironwood.

.png)